Píše sa rok 2035 a roboty sú súčasťou takmer každej domácnosti. Riadia sa základnými pravidlami, ktoré im definoval spisovateľ Izák Assimov už v päťdesiatych rokoch 20. storočia vo svojej poviedke Runaround. Sú jednoduché:

- Robot nesmie ublížiť človeku alebo svojou nečinnosťou dopustiť, aby mu bolo ublížené.

- Robot musí poslúchnuť človeka, okrem prípadov, keď je to v rozpore s prvým zákonom.

- Robot sa musí chrániť pred poškodením, okrem prípadov, keď je to v rozpore s prvým alebo druhým zákonom.

Niektoré z nich sa však rozhodli, že sa nimi prestanú riadiť a skúsia ovládnuť svet. Našťastie, iba vo filmovom spracovaní, ktoré poznáme pod názvom „Ja Robot”.

Realita

Hoci v úvode hovoríme o sci-fi predstave, umelá inteligencia a počítače sa už aj dnes musia veľmi jasne a rýchlo rozhodnúť v rôznych životu nebezpečných okolnostiach. Na prvý pohľad jednoduché pravidlá tak dostávajú zaťažkávaciu skúšku.

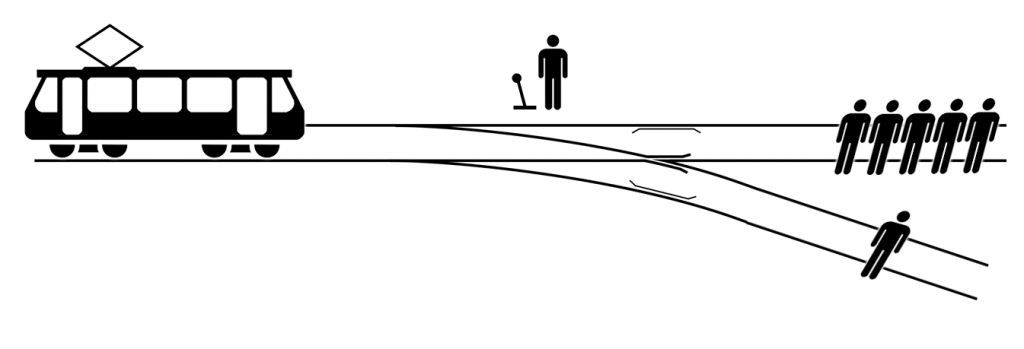

Autonómne automobily, ktoré neustále vyhodnocujú situáciu okolo seba, sa môžu dostať do situácie, kedy je ublíženie človeku nezvratné. Ako sa majú v tomto prípade rozhodnúť? Je morálnejšie a etickejšie obetovať jedného človeka, aby ste zachránili ďalších piatich? Túto otázku si kládol aj filozof Philipp Foot takmer pred 50 rokmi v experimente známom aj ako „The trolley dilemma“.

Počítače nemajú pud sebazáchovy. Nerozhodujú sa v poslednej sekunde na základe pocitov alebo náhody. Postup majú naprogramovaný. Ako ich teda naučiť rozmýšľať eticky a morálne, aby sa zachovali v takýchto situáciách rovnako ako človek a navyše ešte správne?

Veľká výzva

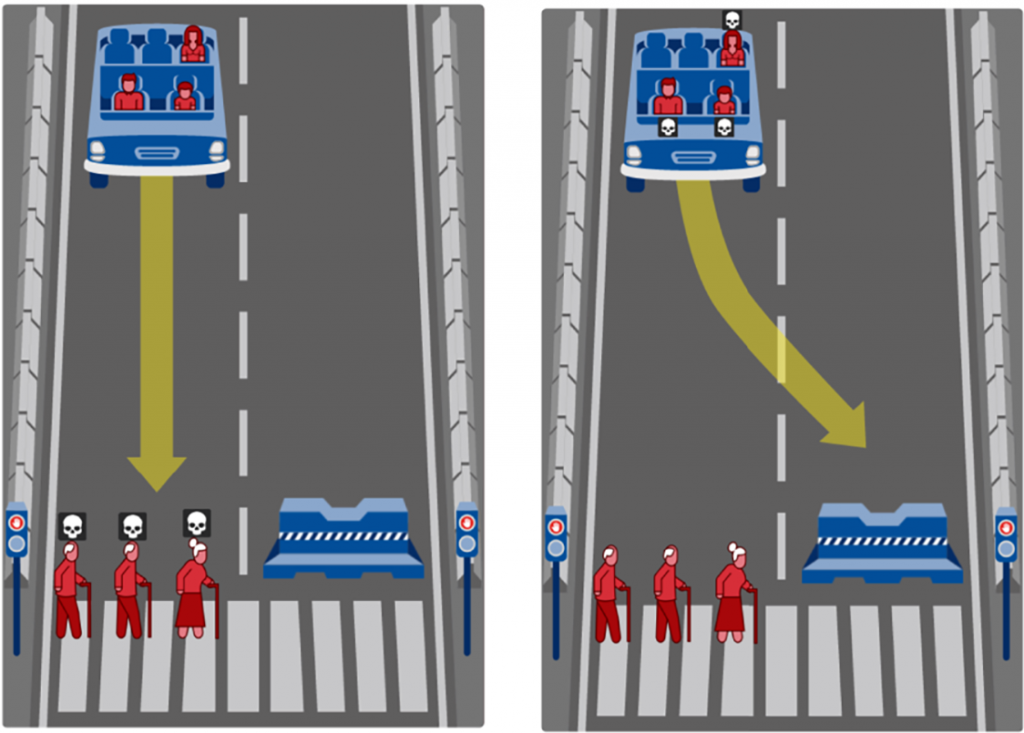

Odpoveď na túto otázku hľadali vedci z Massachusettského technického inštitútu. Vyvinuli „morálny stroj” – ten mal preskúmať dilemy, ktorým môžu čeliť autonómne vozidlá v každodennej premávke. Na pomoc s odpoveďami prišlo 40 miliónov ľudí z viac než 200 kútov sveta.

Uprednostniť viac životov? Mladých ľudí pred staršími alebo chodcov, ktorí dodržiavajú pravidlá cestnej premávky pred tými, ktorí nedodržiavajú? Už len kombinácia všetkých týchto preferencií priniesla milión rôznych scenárov.

Ďalšia výzva situáciu ešte viac skomplikovala. Dáta museli odzrkadľovať rôzne etické alebo kultúrne prístupy v jednotlivých častiach sveta. Inak predsa rozmýšľajú Japonci a inak ľudia v arabských krajinách. Vznikla tak séria rôznych testov, ktoré skúšali ľudskú morálku v situáciách s nezvratným koncom.

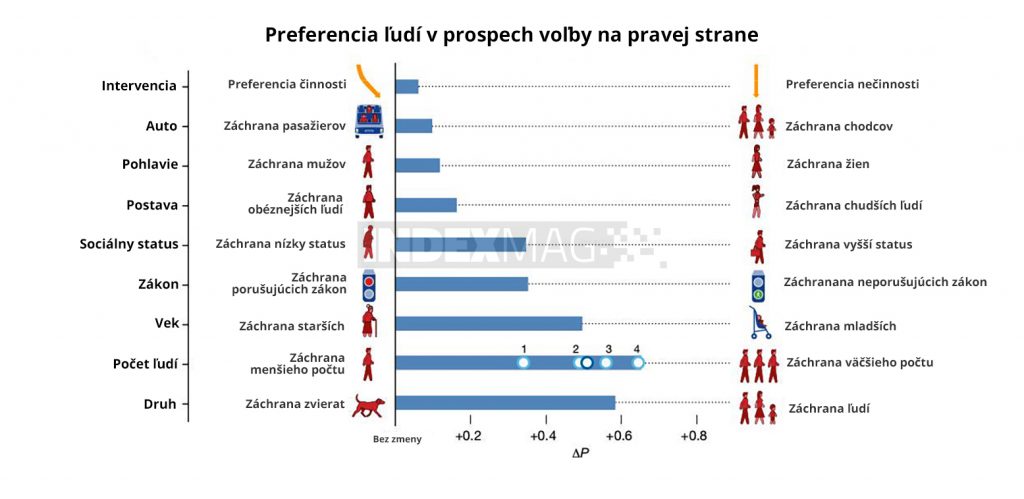

Tie pomohli vedcom poznať preferencie ľudí. Uprednostnili by ľudský život pred tým zo živočíšnej ríše, väčšiu skupinu pred menšou alebo mladého človeka pred starším.

Etika nášho zmýšľania

Edmond Awad, jeden z autorov výskumu, uviedol ako príklad sociálne postavenie človeka. „Zdá sa, že si ľudia myslia, že je v poriadku ušetriť vyššie postaveného človeka v porovnaní s tým nižšie postaveným,“ povedal.

Zároveň ale dúfa, že výsledky pomôžu technológom hlbšie sa zamyslieť nad etikou umelej inteligencie aj mimo áut. „Použili sme ,The trolley dilemma’, pretože je to veľmi dobrý spôsob, ako zbierať údaje. Dúfame, že diskusia o etike však nezostane iba v tejto rovine,” povedal. „Mala by prejsť skôr na analýzu rizík – o tom, kto je viac alebo menej ohrozený – namiesto toho, aby sme hovorili, kto zomrie a kto nie.“

Hoci vedecká obec disponovala prieskumom na veľkej vzorke, zatiaľ jediný oficiálny dokument, zaoberajúci sa touto tematikou, vznikol v Nemecku pred dvoma rokmi. Človek sa síce podvedome rozhoduje na základe špecifických znakov, ako je vek, postavenie pohlavie a podobne, nemecké pravidlá ale jasne takéto triedenie zakazujú. Tvorcovia zákonov a pravidiel tak stoja pred dilemou, či sa priklonia na stranu verejnej mienky, alebo dostatočne verejnosti vysvetlila svoj odlišný postoj.

„V posledných dvoch-troch rokoch začali ľudia konečne hovoriť aj o etike v umelej inteligencii,“ povedal Awad. „Viac z nich si začalo uvedomovať, že to môže mať rôzne etické dôsledky na rôzne skupiny ľudí. Už len skutočnosť, že vidíme ľudí, ktorí sa touto témou aktívne zaoberajú, je naozaj sľubná.“

Doposiaľ sme nikdy v histórii ľudstva nedovolili, aby stroj sám rozhodoval o tom, kto by mal žiť a kto by mal za zlomok sekundy zomrieť. Túto hranicu sa chystáme čoskoro prekročiť a stane sa to v situácii, v ktorej sa ocitáme denne. V premávke. Skôr než rozkážeme autonómnym autám prijať ťažké morálne rozhodnutia, musíme diskutovať a dôjsť k jasným pravidlám v morálnych algoritmoch.

[…] Vývoj aplikácie, ktorá dokáže dôsledne a správne identifikovať druh, je ambicióznym prvkom umelej inteligencie. Cez algoritmus, kódovaný rozhodovací proces, musia prejsť stovky tisíc obrázkov, aby sme […]